Comment fonctionnent les réponses des IA génératives ?

Points clés de l'article

- Les LLM fonctionnent selon deux modes : base de connaissances (données d'entraînement) ou recherche web en temps réel (RAG)

- L'IA décide de chercher sur le web quand elle détecte une incertitude ou un besoin de données fraîches

- Le query fan-out décompose chaque question en plusieurs sous-requêtes pour explorer tout le champ sémantique

- ChatGPT utilise ~25 sources par réponse contre ~10 pour Perplexity, avec seulement 6% de sources communes

- Les sources viennent du top 10-30 des SERP : le SEO reste la base du GEO

- L'IA privilégie les contenus bien structurés, récents et faciles à extraire

- Les données structurées aident les LLM à comprendre le contexte de votre contenu

En 2026, une part croissante des internautes ne clique plus sur des liens. Ils posent directement leurs questions à ChatGPT, Perplexity ou Gemini et attendent une réponse synthétisée.

Mais comment ces IA construisent-elles leurs réponses ? D'où viennent les informations qu'elles citent ?

Pour optimiser sa visibilité dans les moteurs IA (ce qu'on appelle le GEO — Generative Engine Optimization), il faut d'abord comprendre leur fonctionnement. C'est ce qu'on va décortiquer dans cet article.

Les deux modes de réponse des LLM

Quand vous posez une question à une IA, elle peut répondre de deux manières très différentes. Comprendre cette distinction est fondamental.

Mode 1 : Réponse depuis la base de connaissances

Dans ce mode, l'IA répond uniquement à partir de ce qu'elle a appris pendant son entraînement. Elle ne va pas chercher d'information sur Internet.

Comment ça marche concrètement ?

Le modèle a été entraîné sur des milliards de textes : articles, livres, sites web, forums... Pendant cet entraînement, il a appris des relations statistiques entre les mots et les concepts. Quand vous lui posez une question, il génère une réponse en prédisant les mots les plus probables dans ce contexte.

Le LLM ne "sait" pas au sens humain du terme. Il a appris des patterns et génère du texte cohérent basé sur ces patterns.

Les limites de ce mode :

- Date de coupure : les connaissances s'arrêtent à la date d'entraînement

- Hallucinations : si l'information manque, l'IA peut inventer une réponse convaincante mais fausse

- Pas de vérification : aucune source externe pour valider les affirmations

Mode 2 : Réponse avec recherche web (RAG)

Dans ce mode, l'IA combine ses connaissances internes avec des sources externes récupérées en temps réel sur le web. On parle de RAG (Retrieval-Augmented Generation).

C'est ce mode qui nous intéresse pour le GEO. Quand l'IA cite des sources, c'est qu'elle a activé la recherche web.

Quand l'IA décide-t-elle de chercher sur le web ?

L'IA ne lance pas systématiquement une recherche. Elle évalue d'abord son niveau d'incertitude sur la question posée.

Signaux qui déclenchent une recherche web :

- Requêtes qui nécessitent des données fraîches (actualités, prix, événements récents)

- Questions qui exigent des informations vérifiables (chiffres, statistiques, faits précis)

- Recherches liées au e-commerce (comparatifs produits, avis, prix)

- Sujets où le modèle détecte une incertitude dans ses connaissances

À l'inverse, pour des questions de culture générale ou des concepts bien établis, l'IA répond souvent directement depuis sa base de connaissances.

Le processus complet d'une réponse avec recherche web

Quand l'IA décide de chercher sur le web, elle suit un processus en plusieurs étapes. C'est là que ça devient intéressant pour comprendre comment apparaître dans ses réponses.

Étape 1 : Analyse du prompt

L'IA analyse votre question pour en comprendre l'intention de recherche. Elle identifie :

- Le sujet principal

- Les sous-thématiques implicites

- Le niveau de détail attendu

- Le contexte (localisation, langue, historique de conversation)

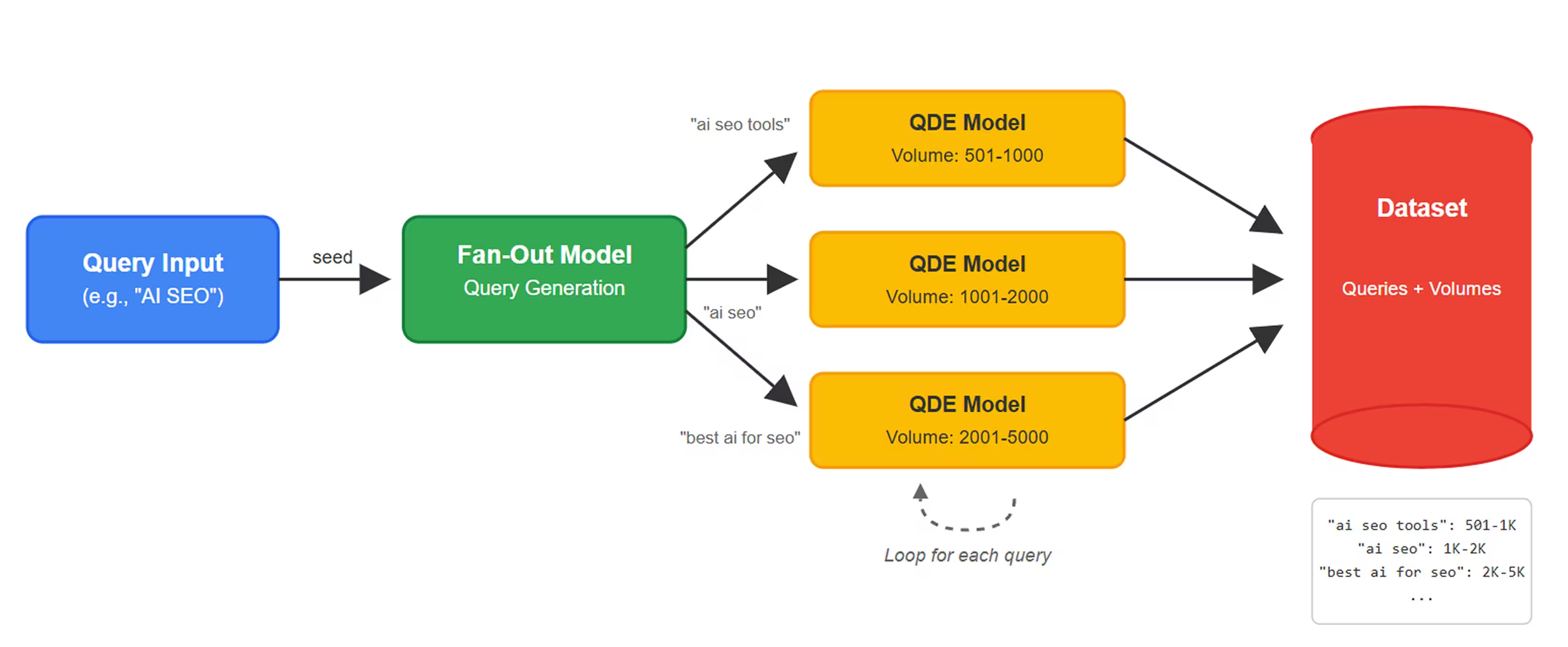

Étape 2 : Query fan-out (décomposition en sous-requêtes)

C'est l'étape clé. L'IA ne lance pas une seule recherche correspondant à votre question. Elle décompose votre prompt en plusieurs sous-requêtes pour explorer différents angles du sujet.

Exemple concret :

Vous demandez : "Quelle est la meilleure stratégie SEO pour un e-commerce en 2026 ?"

L'IA génère plusieurs sous-requêtes :

- "stratégie SEO e-commerce 2026"

- "tendances SEO 2026"

- "optimisation fiche produit SEO"

- "SEO technique e-commerce"

- "link building e-commerce"

- "Core Web Vitals impact SEO"

Ce mécanisme s'appelle le query fan-out. Il permet à l'IA de couvrir l'ensemble du champ sémantique de votre question.

Les chiffres clés :

- ChatGPT lance en moyenne 2,5 recherches par prompt

- ChatGPT exploite en moyenne 25 sources par réponse

- Perplexity (version gratuite) lance 1 recherche et utilise environ 10 sources

- ChatGPT formule parfois ses requêtes en anglais, même pour des questions en français

Étape 3 : Recherche et récupération des sources

L'IA envoie ses sous-requêtes aux moteurs de recherche. Chaque LLM utilise des sources différentes :

- ChatGPT : mix Google + Bing

- Perplexity : principalement Google

- Gemini : Google Search

- Copilot : Bing

Les résultats récupérés viennent généralement du top 10 à top 30 des SERP. L'IA ne va pas chercher en page 5 de Google.

Point important pour le GEO : pour apparaître dans les réponses des IA, il faut d'abord être bien positionné en SEO sur les sous-requêtes générées par le query fan-out.

Étape 4 : Évaluation et sélection des sources

L'IA ne prend pas toutes les sources au même niveau. Elle évalue :

- La pertinence par rapport à la question

- La fiabilité perçue du site (autorité, E-E-A-T)

- La fraîcheur du contenu (date de publication/mise à jour)

- La structure du contenu (facilité d'extraction de l'information)

Les contenus bien structurés avec des titres clairs, des réponses directes et des données factuelles sont privilégiés. L'IA doit pouvoir extraire facilement l'information.

Étape 5 : Synthèse et génération de la réponse

L'IA compile les informations des différentes sources pour générer une réponse unique et cohérente. Elle :

- Croise les informations pour identifier les consensus

- Reformule dans un style fluide et naturel

- Ajoute des citations vers les sources utilisées (selon les LLM)

- Structure la réponse pour qu'elle soit directement utilisable

Schéma : Du prompt à la réponse

Les différences entre les LLM

Tous les LLM ne fonctionnent pas de la même manière. Voici ce qui distingue les principaux.

ChatGPT (OpenAI)

ChatGPT propose deux modes :

- Sans recherche web : répond depuis sa base de connaissances (date de coupure)

- Avec recherche web : active automatiquement ou manuellement la navigation

Quand la recherche est activée, ChatGPT est le plus "gourmand" en sources : 25 sources en moyenne par réponse, avec 2,5 recherches par prompt.

Particularité : ChatGPT formule souvent une partie de ses requêtes en anglais, même pour des questions en français.

Perplexity

Perplexity est toujours connecté au web. C'est sa raison d'être : un moteur de réponse, pas un chatbot.

Il utilise principalement Google comme source et affiche systématiquement les citations avec liens vers les sources. La version gratuite lance environ 1 recherche par prompt et utilise une dizaine de sources.

Perplexity formule des requêtes très proches du prompt original, contrairement à ChatGPT qui explore davantage.

Google AI Overviews / AI Mode

Google AI Overviews (anciennement SGE) et AI Mode sont intégrés directement dans les résultats de recherche Google.

L'avantage : ils s'appuient sur l'index Google complet. Les sources citées sont généralement celles qui apparaissent dans le top 10 des SERP classiques.

C'est le LLM où le SEO traditionnel a le plus d'impact direct sur la visibilité IA.

Gemini

Gemini (Google) fonctionne de manière similaire aux AI Overviews mais dans une interface conversationnelle. Il utilise Google Search pour ses recherches et peut accéder à des données en temps réel.

Claude (Anthropic)

Claude fonctionne principalement sans recherche web dans sa version standard. Il répond depuis sa base de connaissances avec une date de coupure.

Certaines intégrations (comme Claude dans des outils tiers) peuvent ajouter des capacités de recherche, mais ce n'est pas natif.

Ce que ça change pour votre visibilité

Maintenant qu'on comprend le fonctionnement, qu'est-ce que ça implique concrètement pour apparaître dans les réponses des IA ?

Le SEO reste la base

Pour apparaître dans les sources des IA, il faut d'abord être bien positionné sur Google et Bing. Les LLM récupèrent leurs sources dans le top 10-30 des SERP.

Pas de raccourci : le GEO commence par un bon SEO.

Couvrir le champ sémantique complet

Avec le query fan-out, l'IA ne cherche pas votre mot-clé exact. Elle explore tout le champ sémantique autour de la question.

Conséquence : vos contenus doivent couvrir un sujet de manière exhaustive, pas juste répondre à une requête précise. Les clusters thématiques et les contenus piliers prennent tout leur sens.

Faciliter l'extraction d'information

L'IA doit pouvoir extraire facilement les informations de votre contenu. Pour ça :

- Titres explicites (H2, H3) qui annoncent clairement le contenu

- Réponses directes aux questions dans les premiers paragraphes

- Listes et tableaux pour les informations factuelles

- Paragraphes courts (2-4 phrases max par idée)

Un contenu IA-friendly est avant tout un contenu humain-friendly. Si un lecteur peut scanner votre article et trouver rapidement l'info qu'il cherche, l'IA aussi.

Les données structurées

Les données structurées (Schema.org) aident les IA à comprendre la nature et le contexte de votre contenu. Elles permettent d'identifier clairement :

- Qui est l'auteur (crédibilité, E-E-A-T)

- Quelle est l'entité décrite (entreprise, produit, personne)

- Quelles sont les questions/réponses (FAQPage)

- Quelle est la date de publication/mise à jour

👉 On a rédigé un guide complet sur le sujet : Quelles données structurées implémenter pour le SEO et le GEO ?

La fraîcheur du contenu

Les IA privilégient les contenus récents et mis à jour. Un article de 2022 aura moins de chances d'être cité qu'un contenu actualisé en 2026.

Pensez à mettre à jour vos contenus clés et à indiquer clairement la date de dernière modification.

Notre point de vue chez Vydera

Chez Vydera, on accompagne nos clients sur le GEO depuis plusieurs mois. Voici ce qu'on observe sur le terrain.

Le GEO n'est pas une révolution, c'est une évolution.

Les fondamentaux restent les mêmes : créer du contenu de qualité, bien structuré, qui répond vraiment aux questions des utilisateurs. Ce qui change, c'est l'importance de certains signaux qu'on négligeait parfois :

- La couverture sémantique complète d'un sujet (pas juste un mot-clé)

- La structure éditoriale qui facilite l'extraction

- Les données structurées qui explicitent le contexte

- La fraîcheur et la mise à jour régulière

Ce qui nous surprend :

Seulement 6% des sources sont communes entre ChatGPT et Perplexity pour un même prompt. Ça veut dire que pour être visible sur les deux, il faut potentiellement doubler ses efforts. Chaque LLM a ses propres critères de sélection.

Notre conseil :

Ne partez pas de zéro. Commencez par analyser comment votre marque apparaît (ou pas) dans les réponses des IA sur vos requêtes clés. Identifiez les sources citées par les LLM sur votre thématique. Puis optimisez vos contenus existants avant d'en créer de nouveaux.

Conclusion

Les IA génératives ne "cherchent" pas une réponse comme un moteur de recherche classique. Elles la construisent en combinant leurs connaissances internes et des sources web récupérées en temps réel.

Le mécanisme du query fan-out est central : l'IA décompose votre question en sous-requêtes pour explorer tout le champ sémantique. Pour apparaître dans ses réponses, il faut donc :

- Être bien positionné en SEO sur les sous-requêtes potentielles

- Couvrir le sujet de manière exhaustive (clusters thématiques)

- Structurer le contenu pour faciliter l'extraction d'information

- Implémenter les données structurées pour expliciter le contexte

- Maintenir la fraîcheur du contenu

Le GEO commence par un bon SEO. Mais il demande une approche plus globale, centrée sur la couverture sémantique et la qualité structurelle des contenus.

Sans recherche web, l'IA répond uniquement depuis ses données d'entraînement avec une date de coupure fixe et un risque d'hallucination. Avec recherche web (mode RAG), elle interroge Google ou Bing en temps réel pour récupérer des sources actualisées et générer une réponse plus fiable et sourcée.

Le query fan-out est le mécanisme par lequel l'IA décompose votre question en plusieurs sous-requêtes avant de lancer ses recherches. Par exemple, une question sur la stratégie SEO e-commerce génère des recherches sur les tendances, le SEO technique, le link building, etc. Cela permet de couvrir l'ensemble du sujet.

Chaque LLM utilise des moteurs de recherche différents (ChatGPT : Google + Bing / Perplexity : Google), formule ses requêtes différemment et sélectionne ses sources selon ses propres critères. Résultat : seulement 6% des sources sont communes entre les deux pour un même prompt.

Il faut d'abord être bien positionné en SEO car les LLM récupèrent leurs sources dans le top 10-30 des résultats Google/Bing. Ensuite, structurez vos contenus pour faciliter l'extraction (titres explicites, réponses directes, paragraphes courts) et implémentez les données structurées pour expliciter le contexte.

Oui, le SEO reste fondamental pour le GEO. Les IA ne créent pas leurs propres sources : elles récupèrent des contenus déjà bien positionnés sur les moteurs de recherche. Sans visibilité SEO sur les sous-requêtes générées par le query fan-out, vos contenus ne seront pas inclus dans les réponses des LLM.

.svg)